Corona und die künstliche Intelligenz

Was hat das denn nun wieder miteinander zu tun?

Auch wenn es nicht jedem offensichtlich erscheint – für mich: jede Menge!

Als mich nun auch (endlich?) Corona erwischt hat, sperrte mich meine Frau (zu Recht!) in mein sehr wohnliches Arbeitszimmer ein.

Klar, sobald ich einen Rechner um mich rum habe, sitze ich natürlich auch dran. Und so begann ich, mich mit einem Thema auseinander zu setzen, mit dem ich mich schon lange einmal befassen wollte: Text to Image AI Generatoren.

Disco Diffusion

Was`n das nun schon wieder? Nun ja, aufgefallen sind mir diese „wiered“ Bilder in sozialen Medien, die immer im Kontext mit „Disco Diffusion“ erwähnt werden. Vor allem die Bilder von Michi sind mir immer wieder faszinierend aufgefallen: https://www.facebook.com/michael.mueller.9216/

Disco Diffusion ist eine frei verfügbare Software-Anwendung, mit der man mittels einer künstlichen Intelligenz Bilder oder Videos aus Text generieren lassen kann. Die Software ist in Python geschrieben und ist dafür gedacht, auf Google Colab Notebooks ausgeführt zu werden. Colab oder Colaboratory von Google ist eine online Entwicklungs-Umgebung, die in den eigenen Google Drive Speicherplatz kopiert wird und dort Zugriff auf GPUs, also Rechenleistung erhält.

Folgt man also nun der wirklich guten Anleitung von Harmeet auf seinem Blog, kann man – vorausgesetzt man hat ein Google Drive – gleich beginnen seine ersten Bilder zu kreieren:

https://weirdwonderfulai.art/resources/getting-started-with-disco-diffusion/

Irgendwie macht dieses Stück Software so süchtig, dass man gar nicht mehr aufhören möchte

Ein paar Beispiele machen deutlich, was die Software kann und auch, wo Ihre Grenzen sind:

„A wide landscape in the desert with a apocalyptic touch“, „the sky is clear purple and blue shining“, „The scene is inspired by Salvadore Dali“, „purple color scheme“

„a scenery of the rough ocean with a huge monster riding the waves with a stormy coast, Trending on artstation.“, „blue color scheme“

„A VR 3d sci-fi house in a phantastic forest with ivy growing on the trees, light shining across the trees by Curt C. Smith, Trending on artstation.“, „brown color scheme“

Krass oder? Auf jeden Fall völlig faszinierend, was Disco Diffusion aus diesem Text erzeugen kann, auch wenn es eher surreale Szenen sind.

Deepdream

Wesentlich konkreter dagegen ist deepdream. Dass wir die Vorgehensweise dieser Anwendung als „normal“ empfinden liegt daran, dass es schon „normal“ geworden ist, dass wir Bilder durch einen Filter jagen. Aber auch dahinter steckt wieder eine KI. Nach einer Anmeldung auf der Seite https://deepdreamgenerator.com/ erhält man Credits, die „Compute Energy“ genannt werden, die alle paar Stunden aufgeladen werden, um eine zu hohe Serverlast zu vermeiden. Zuerst beginnt man munter Bilder hochzuladen. Einerseits Bilder, die man verändern möchte, andererseits Bilder die den Style definieren, in die man später Bilder konvertieren will, also Strukturen, Vorlagebilder, oder Gemälde. In drei Schritten definiert man als erstes 1. das „Base Image“, 2. das „Style Image“ und beginnt mit 3. „Generate“ das neue Bild zu berechnen.

Auch hier zeigen erst die Beispiele wieder, welches Potential in der Anwendung steckt.

Ein Portrait kombiniert mit einem Kunstwerk der Berliner Mauer

Oder eines meiner Renderings kombiniert mit meinem Lieblingsbild „Nighthawks“ von Edward Hopper.

Oder eines meiner Renderings kombiniert mit meinem Lieblingsbild „Nighthawks“ von Edward Hopper.

Schon wieder krass oder?

Dall-e

Der Kinofilm „WALL·E – Der Letzte räumt die Erde auf“ diente gemeinsam mit dem weltberühmten Maler Salvadore Dali als Nmensgeber für das nächste künstliche Netzwerk. Dall-e wurde im Jahr 2021 von dem Unternehmen OpenAI entwickelt, das von Elon Musk und Microsoft finanziert, die Weiterentwicklung und Vermarktung von künstlichen Intelligenz- Anwendungen erforscht. (Man denkt natürlich sofort: Aha alte Bekannte!)

Dall-e muss wohl so unglaublich viel Eindruck hinterlassen haben, dass man bereits eine sogenannte „Allgemeine künstliche Intelligenz“ dahinter vermutete, also eine KI, die dem Menschen so ähnlich ist, dass sie jegliche Aufgabe verstehen und erlernen kann. Da die KI jedoch den Entwicklern zufolge noch gravierende Fehler macht, hat man sie noch nicht der Öffentlichkeit zugänglich gemacht. Einige beeindruckende Beispiele findet man jedoch im Blog von OpenAI: https://openai.com/blog/dall-e/

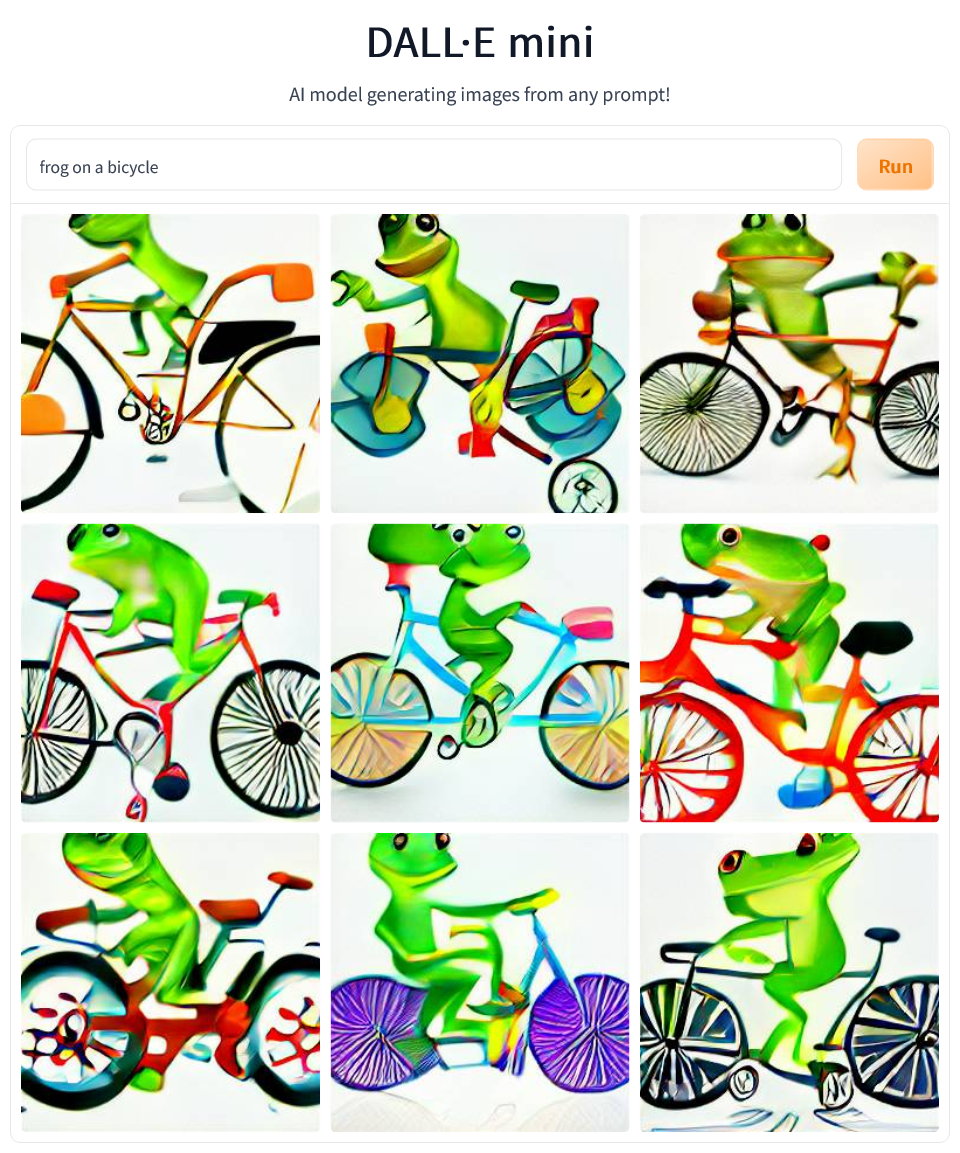

Stattdessen wurde die vereinfachte Version Dall-e Mini veröffentlicht. Unter der Adresse https://huggingface.co/spaces/dalle-mini/dalle-mini kann jeder einmal testen, wohin die Reise mit den KIs gehen wird.

Wohin die Reise gehen wird,

ist tatsächlich eine sehr spannende Frage! Meine primäre Faszination und Begeisterung für diese beinahe unheimlich erscheinende Technologie wurde im Laufe der Zeit von ein wenig nachdenklicheren Gedanken durchsetzt.

Geht da ein Stück Kreativität verlohren?

Verlieren wir nicht auch ein Stück Kontrolle über Inhalte?

Wenn das in 2d geht, wird das auch in 3d gehen, so dass KIs virtuelle Räume für uns Menschen erschaffen werden?

Wenn das mit Text zu Bild geht, dann geht das sicherlich auch mit Text zu Article?

Was können wir überhaupt noch wem glauben?

Es hinterlässt ein komisches Bauchgefühl…

Fakt ist jedoch, dass Photoshop mit seinen „Neural Filters“ bereits jetzt Technologien aus dem maschinellen Lernen integriert hat, mit denen man Bilder ganz einfach so manipulieren kann, dass Bild-Inhalte einfach verfremdet werden können: https://helpx.adobe.com/de/photoshop/using/neural-filters.html

Aber können wir das nicht schon lange?

Tags: ARCoreAugmented Realitygeolocation-basedGlassesGoogleWebGL